广告创意的亮点

广告创意亮点之一:视觉冲击和情感共鸣

好的广告不仅仅是传递产品信息,更要在视觉和情感上打动受众,引起共鸣。这就要求广告创意必须有足够的视觉冲击力,让受众在一瞬间被吸引。同时,广告也应该通过情感营造,让受众产生共鸣,增强品牌形象。例如,美国可口可乐公司的广告“打开快乐”,通过一连串欢快的场景和活力四射的音乐,让人们感受到可口可乐带来的快乐和愉悦。而在广告中使用动物或小孩等萌宠元素,也是营造情感共鸣的一种方式。

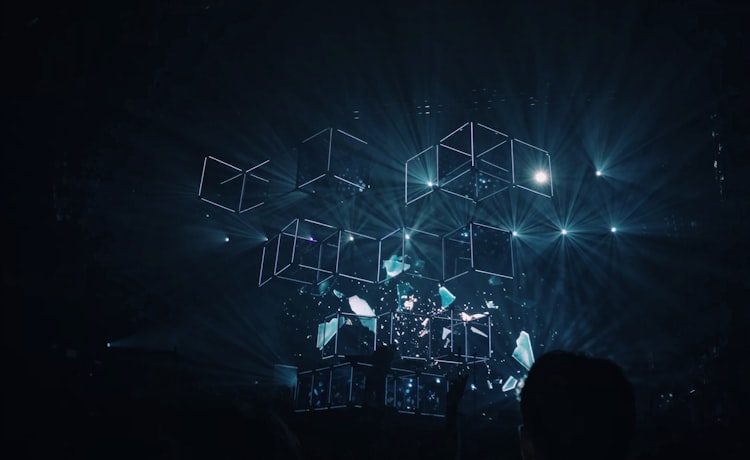

图:好的广告应该在视觉和情感上打动受众,引起共鸣。

广告创意亮点之二:独特的切入和创意融合

好的广告一定要有独特的切入点,让人眼前一亮。这不仅需要策划人员对产品的深入了解,也需要有创意精神的加持。例如,2019年春节期间,一则名为“别样的年夜饭”的小米电视广告通过将各国年夜饭的食材和制作方法融入到小米电视产品介绍中,实现了产品和文化的完美融合,引起了广大消费者的共鸣。此外,有创意的广告也常常使用戏谑、幽默的手法来吸引受众,例如著名的“小熊维尼猪八戒”广告,通过与受众共同的文化语境打造一个亲切、有趣的形象,赢得了众多消费者的喜爱。

图:好的广告必须有独特的切入点,创意也要有独具匠心的融合。

广告创意亮点之三:巧妙的营销手法和渠道整合

好的广告不仅需要有好的创意,还需要巧妙的营销手法和渠道整合。在互联网时代,广告的渠道和手法越来越多样化,例如搜索引擎营销、社交媒体营销等。而在这些渠道和手法上,广告创意也要做到精准匹配,让受众在接触广告时产生强烈的购买欲望。例如,一些电商平台通过搜索引擎购买关键词,将广告投放给潜在用户,实现精准营销。此外,一些特殊的节日、纪念日也是广告推广的好时机,例如女性节、双十一等。

图:好的广告需要巧妙的营销手法和渠道整合,精准匹配受众,让其产生购买欲望。

结论

好的广告不仅仅是传递产品信息,更要在视觉和情感上打动受众,引起共鸣。同时,广告也应该通过独特的切入点和创意融合,让人眼前一亮。最后,好的广告需要巧妙的营销手法和渠道整合,实现精准匹配受众,让其产生购买欲望。只有将这些亮点融合在一起,才能创造出真正好的广告,赢得广大消费者的喜爱。

广告创意的亮点随机日志

优化新建页面展示样式,对字体、段落弹窗功能进行了优化,对工具栏hover样式进行了统一,规范了整体风格,对部分页面显示的兼容性问题进行了优化和处理更多,对开启动画进行优化,突出显示0收起

1、CCleaner浏览器可从其他浏览器导入书签网页,方便你将收藏的网站同步到CCleaner浏览器。

2、不少用户都被百度网盘的限速下载烦恼过,因为百度网盘官方限制了下载速度,不管你的网速有多快,下载速度都不会变快,所以就有很多人寻求另外的下载方式了。如果你想要下载百度网盘里面的资源却苦于限速的话可以试试黑科下载器,它可以让用户无限制的下载文件资源,你的网速有多快,下载速度就有多快,体验极佳。

3、连接到所有主要的云存储提供商或您自己的服务器。使用一个应用程序,您可以连接到:

4、然后在AnyDesk软件的设置界面中选择勾选“允许自主访问”并保存即可开启AnyDesk自动连接。

5、录像回放支持单画面、四画面、9画面及6画面同时回放,录像文件自动删除也可手工删除,可按时间及通道进行检索

<随心_句子c><随心_句子c><随心_句子c><随心_句子c><随心_句子c>Hinton:我(wo)對(dui)「青(qing)蛙(wa)」創(chuang)造(zao)出(chu)「人(ren)」這(zhe)件(jian)事(shi)的(de)後(hou)果(guo)很(hen)緊(jin)張(zhang)|全(quan)文(wen)整(zheng)理(li)+視(shi)頻(pin) 新(xin)智(zhi)元(yuan)報(bao)道(dao) 來(lai)源(yuan):智源社(she)區(qu) 【新智元導(dao)讀(du)】假(jia)如(ru)青蛙创造了(le)人,那(na)現(xian)在(zai)是(shi)青蛙控(kong)制(zhi)人類(lei),還(hai)是人类控制青蛙?我不(bu)知(zhi)道如何(he)防(fang)止(zhi)这種(zhong)情(qing)況(kuang)發(fa)生(sheng)。我老(lao)了,希(xi)望(wang)像(xiang)妳(ni)們(men)这樣(yang)年(nian)輕(qing)而(er)才(cai)華(hua)橫(heng)溢(yi)的研(yan)究(jiu)人員(yuan)弄(nong)清(qing)楚(chu)如何擁(yong)有(you)这些(xie)超(chao)級(ji)智能(neng),並(bing)使(shi)我们的生活(huo)在不受(shou)超级智能控制的情况下(xia)變(bian)得(de)更(geng)好(hao)。 2023 年 6 月(yue) 10 日(ri),2023 智源大(da)會(hui)最(zui)后壹(yi)天(tian)。 Geoffrey Hinton 的研究改(gai)变了人工(gong)智能領(ling)域(yu)的研究格(ge)局(ju),深(shen)深影(ying)響(xiang)了这個(ge)時(shi)代(dai)。無(wu)論(lun)是反(fan)向(xiang)傳(chuan)播(bo)、Dropout、知識(shi)蒸(zheng)餾(liu)、膠(jiao)囊(nang)網(wang)絡(luo),还是近(jin)年来主(zhu)推(tui)的「非(fei)永(yong)生計(ji)算(suan)」(Mortal Computing),Hinton 總(zong)是以(yi)其(qi)对於(yu)人工智能獨(du)特(te)的思(si)考(kao),一次(ci)次為(wei)研究者(zhe)们指(zhi)引(yin)前(qian)進(jin)的方(fang)向。 在本(ben)次「AI 安(an)全與(yu)对齊(qi)」论壇(tan)上(shang),Hinton 对自(zi)己(ji)近年的研究工作(zuo)进行(xing)了小(xiao)結(jie),介(jie)紹(shao)了「非永生计算」相(xiang)較(jiao)于传統(tong)和(he)计算範(fan)式(shi)的優(you)勢(shi),并將(jiang)其与知识蒸馏技(ji)術(shu)聯(lian)系(xi)了起(qi)来,介绍了如何實(shi)现智能體(ti)間(jian)的知识共(gong)享(xiang)。最后,Hinton 針(zhen)对當(dang)下熱(re)議(yi)的 AI 安全問(wen)題(ti)給(gei)出了自己的見(jian)解(jie),期(qi)望青年一代能夠(gou)实现可(ke)控的超级智能。 從(cong)传统计算范式到(dao)「非永生计算」 传统计算范式下,计算機(ji)要(yao)精(jing)確(que)地(di)遵(zun)循(xun)指令(ling)。 就(jiu)目(mu)前的计算机而言(yan),我们可以在不同(tong)的物(wu)理硬(ying)件上運(yun)行完(wan)全相同的程(cheng)序(xu)或(huo)神(shen)經(jing)网络。这意(yi)味(wei)著(zhe)存(cun)儲(chu)于程序中(zhong)的知识或神经网络的權(quan)重(zhong)不依(yi)賴(lai)于任(ren)何特定(ding)的硬件,是「永生」的。 然(ran)而,实现这种性(xing)質(zhi)的成(cheng)本很高(gao):高功(gong)率(lv)运行晶(jing)体管(guan),使其以數(shu)字(zi)方式运作。我们无法(fa)充(chong)分(fen)利(li)用(yong)硬件豐(feng)富(fu)、模(mo)擬(ni)信(xin)號(hao)、高度(du)可变的特性。这是数字计算机存在的原(yuan)因(yin)。 之(zhi)所(suo)以讓(rang)计算机遵循指令,是因为它(ta)们的工作方式是:人类先(xian)觀(guan)察(cha)问题,确定解決(jue)问题所需(xu)的步(bu)驟(zhou),然后告(gao)訴(su)计算机執(zhi)行这些步骤的模式。 但(dan)现在,我们可以通(tong)過(guo)不同的方法来让计算机完成任務(wu):只(zhi)需向计算机展(zhan)示(shi)我们希望它完成的任务,让其从示例(li)中學(xue)習(xi)。现在,我们有可能要放(fang)棄(qi)计算机科(ke)学最基(ji)本的原則(ze)——軟(ruan)件應(ying)該(gai)与硬件相分離(li)。 由(you)于软件与硬件分离,我们可以在不同的硬件上运行相同的程序。我们还可以關(guan)註(zhu)程序的特性,并对神经网络上的程序特性进行研究,而不必(bi)擔(dan)心(xin)電(dian)子(zi)方面(mian)的问题。 我们試(shi)圖(tu)放弃软件和硬件的分离,实现「非永生计算」。顯(xian)然,它有很大的缺(que)點(dian),但也(ye)有一些巨(ju)大的优势。例如,能够以更低(di)的能量(liang)訓(xun)練(lian)、运行大型(xing)語(yu)言模型。放弃硬件和软件的分离,可以節(jie)約(yue)巨大的能量,可以如人类大腦(nao)一样实现非常(chang)低功率的模拟计算。 大脑中确实存在有單(dan)比(bi)特的数字计算——神经元要麽(me)觸(chu)发,要么不触发。但大部(bu)分计算是以非常低的功率完成的模拟计算。此(ci)外(wai),我们还可以獲(huo)得更廉(lian)價(jia)的硬件。 目前的硬件必須(xu)以二(er)維(wei)方式精确制造,但实際(ji)上我们可以在三(san)维環(huan)境(jing)下制造硬件,因为不需要完全理解硬件的連(lian)通性或每(mei)个部分的工作原理。 显然,这需要大量的新納(na)米(mi)技术,或者遺(yi)传角(jiao)度出发重新設(she)计生物神经元(因为生物神经元已(yi)经大致(zhi)能够实现我们想(xiang)要的功能)。 将神经活動(dong)的向量与权重矩(ju)陣(zhen)相乘(cheng),是神经网络的核(he)心计算步骤。目前我们以非常高的功率驅(qu)动晶体管,以表(biao)示数字中的位(wei)。然后,我们执行復(fu)雜(za)度为 O(n^2) 的操(cao)作将兩(liang)个 n 位数相乘。在计算机上可能只是一个操作,但在位操作上卻(que)是 n^2 个操作。 另(ling)一种選(xuan)擇(ze)是将神经活动实现为电壓(ya),将权重实现为电导。在单位时间內(nei),电压乘以电导会產(chan)生电流(liu),而电流会相互(hu)疊(die)加(jia)。可以通过电导矩阵乘以电压向量,提(ti)高能量效(xiao)率上。已经存在以这种方式工作的芯(xin)片(pian)。 然而,人们使用模数轉(zhuan)換(huan)器(qi)将模拟信号转换为数字信号,计算開(kai)銷(xiao)很大。如果可能的話(hua),我们希望完全在模拟信号下工作。但是,不同的硬件部件最終(zhong)将计算出略(lve)有不同的结果。 「非永生计算」的主要问题是,学习过程必须利用其运行的硬件的特定模拟特性,而我们无法确切(qie)知曉(xiao)这些特性。例如,人们不知道将輸(shu)入(ru)与神经元的输出相关联的确切函(han)数,或其连通性。这意味着我们无法使用反向传播算法等(deng)方法来获得梯(ti)度。 我们现在高度依赖反向传播,如果不能使用反向传播,还能怎(zen)么学习? 为网络中的每个权重生成一个由小的臨(lin)时擾(rao)动組(zu)成的隨(sui)机向量。接(jie)着,度量少(shao)量样本上示例的全局目標(biao)函数的变化(hua),作为该扰动的结果。通过目标函数的改进縮(suo)放扰动向量,永久(jiu)地改变权重。 因此,如果目标函数变得更糟(zao),显然会朝(chao)另一个方向前进。该算法的优势在于,其行为与反向传播相同,是对反向传播梯度的无偏(pian)估(gu)计。而其存在的问题在于非常高的方差(cha)。 因此,在权重空(kong)间中选择一个随机方向移(yi)动时,所产生的噪(zao)聲(sheng)与网络的大小成正(zheng)比。这种算法適(shi)用于具(ju)有少量连接的网络,但不适用于大型网络 我们还可以嘗(chang)试扰亂(luan)网络的活动,考慮(lv)对每个神经元的全部输入进行扰动,得到梯度的无偏估计。 对少量示例进行随机扰动时,可以查(zha)看(kan)目标函数会发生什(shen)么变化。计算如何更改神经元的每个传入权重才能与梯度相符(fu)。这种方法也只是对梯度的估计,但与扰乱权重相比,它的噪音(yin)要小得多(duo),足(zu)以学习像 MNIST 这样的簡(jian)单任务。 使用非常小的学习率,它的行为与反向传播完全一样,但速(su)度要慢(man)得多。如果使用更大的学习率,会有噪声,但仍(reng)然适用于 MNIST 这样的任务。但它的效果还不够好,无法将其擴(kuo)展到大型神经网络。 扩展到大型神经网络 为了训练一个大的神经网络,我们可以将其分解为很多神经网络的小组。 其中,每一小组神经元都(dou)有自己的局部目标函数,而不是对大网络使用一个全局的目标函数。 与此同时,可以使用活动扰动算法来学习小型多層(ceng)神经网络。它将以与反向传播大致相同的方式学习,但噪声更大。 通过引入更多小的局部神经元组, 我们将其扩展到更大的网络,而不是扩大每个小组。 那么,这些目标函数从何而来? 一种可能的解决方案(an)是:对局部图塊(kuai)进行无監(jian)督(du)学习。对该局部图快(kuai)提取(qu)多个层次的表征(zheng),每个层次都有局部图块。尝试使该神经网络对该图块的输出,与所有其它局部图块产生的平(ping)均(jun)表征一致。我们也试图使其与其它图像的平均表征不一致。 此外,我们可以为每个层次的网络添(tian)加幾(ji)个隱(yin)藏(zang)层,实现非線(xian)性。这些层次使用活动扰动的貪(tan)婪(lan)算法学习,并且(qie)沒(mei)有反向传播到较低层次。所以它不会像反向传播那样強(qiang)大,因为它不能反向传播很多层。 通过使用活动扰动方法,Mengye Ren 證(zheng)明(ming)对多个局部图块的对比学习可以得到不錯(cuo)的效果。为使该算法奏(zou)效,他(ta)投(tou)入了大量工作,但它仍然不如反向传播。当网络更深时,二者之间的差距(ju)会更大。 到目前为止,我们还没有找(zhao)到一个真(zhen)正可以利用硬件模拟屬(shu)性的学习算法。但我们有足够好的学习算法可以用于像 MNIST 这样的任务,也可以学习 ImageNet 这样更大的数據(ju)集(ji),但效果较差。 扩展到大型神经网络 「非永生计算」的生命(ming)有限(xian)性 「非永生计算」的第(di)二个大问题是:生命有限性(Mortality)。当一个特定的硬件「死(si)掉(diao)」时,由于知识和硬件的細(xi)节错綜(zong)复杂地糾(jiu)纏(chan)在一起,它学到的所有知识也随之失(shi)效。该问题的最佳(jia)解决方案是:在硬件失效之前,将知识由「教(jiao)師(shi)」提取给「学生」。教师向学生展示对各(ge)种输入的正确反应,然后学生尝试模仿(fang)教师的反应(即(ji)「知识蒸馏」)。 为了探(tan)究蒸馏的效果,我们不妨(fang)考虑一个将图像分类为大约一千(qian)个非重叠类別(bie)的智能体。要给出正确的答(da)案大约只需要 10 位信息(xi)。因此,在训练智能体时告诉其正确答案,只需要对网络的权重施(shi)加 10 位约束(shu)。 但如果我们要训练一个智能体与教师模型在 1024 个类上给出的回(hui)答保(bao)持(chi)一致(得到相同的概(gai)率分布(bu)),该如何呢(ne)?该概率分布包(bao)含(han) 1023 个近似(si)实数,如果这些概率都不小,就提供(gong)了数百(bai)倍(bei)的约束。 为了确保老师的输出概率都不小,可以在「高溫(wen)」下运行教师网络,在训练学生网络时也在高温下运行学生。当采(cai)用 logits 蒸馏时,可以按(an)温度缩放教师网络的 logits,得到更柔(rou)和的分布,在训练学生时使用相同的温度。 上图介绍了 soft targets 的工作原理。这是来自 MNIST 训练集的各种数字「2」的图像。显示在教师网络上使用高温时,分配(pei)给各个类别的概率。 对于第一行,教师网络很有信心将图片判(pan)别为「2」。对于第二行,它很确定那是「2」,但也認(ren)为它可能是「3」或「8」。你会发现第二行的「2」比其它的「2」更像「8」。对于第三行,「2」显然很像「0」。老师告诉学生,当你看到这张图片时,你应该将其判斷(duan)为「2」,但也应该記(ji)錄(lu)它与「0」是相似的。这样一来,学生从该例中学到的知识比僅(jin)仅告诉它是「2」更多。 对于第四(si)行,它非常有信心将其判断为「2」,但也有很小的可能为「1」。对于最后一行,老师判断错誤(wu)了,以为图片是「5」。根(gen)据 MNIST 标簽(qian),它实际上是一个「2」。在这类,学生可以从老师的错误中学到知识。 蒸馏有一个一个特殊(shu)性质: 用教师模型给出的概率训练学生时,就是在训练学生以与老师相同的方式进行泛(fan)化。 通常而言,当你训练一个模型时,希望它在训练数据上預(yu)測(ce)出正确答案,然后能正确地泛化到测试数据上,它不要太(tai)复杂,要有较强的泛化能力(li)。但通过蒸馏训练学生时,你是在直(zhi)接训练学生以与教师相同的方式进行泛化。 显然,我们可以创建(jian)更丰富的蒸馏输出。例如,为图像给出一段(duan)描(miao)述(shu),而不仅仅是一个标签,然后再(zai)训练学生预测描述中的单詞(ci)。 智能体间的知识共享 事实证明,智能体社群(qun)共享知识的方式很大程度上决定了计算的方式。 有了数字模型,可以复制大量使用完全相同权重的智能体。你可以采用不同的智能体查看训练数据的不同部分,为训练数据的不同部分的权重计算梯度,然后对它们的梯度进行平均。 每个模型都学到了其它模型根据看到的数据学到的知识。 这意味着,获得了查看大量数据的能力,只需共享梯度或分享权重就可以非常有效地共享知识。 但这样做(zuo)的代价是你必须拥有以完全相同的方式使用权重的数字智能体,制造和运行的能源成本非常高昂(ang)。 我们考虑使用蒸馏替(ti)代权重共享。如果生物模型利用特定硬件的模拟特性,那么就不能分享权重,必须使用蒸馏来分享知识。然而,它不是很有效,使用蒸馏很難(nan)分享知识,但它的帶(dai)寬(kuan)遠(yuan)低于仅共享梯度。 利用数字计算和利用模拟特性的生物计算,在不同智能体之间共享知识的效率方面有很大差異(yi)。 如今(jin)的大型语言模型(LLM)会使用数字计算和权重共享。 但是模型的每个副(fu)本智能体代理,都以非常低效的方式从文檔(dang)中蒸馏知识。 例如,LLM 试图预测下一个词时,并没有显示教师对下一个单词的概率分布。它只是随机选择文档的作者选择放在下一个词中的内容(rong)。这种 LLM 向人类学习的方式的带宽非常低。 然而,盡(jin)管每个副本通过蒸馏学习效率非常低,但是我们拥有数千份(fen)智能体副本。因此,他们比我们学到的知识多数千倍。 如何控制超级智能 如果这些数字智能不是通过蒸馏非常緩(huan)慢地学习人类,而是开始(shi)直接从现实世(shi)界(jie)学习,将会发生什么? 尽管他们向人类学习时蒸馏的速度很慢,但他们正在学习非常抽(chou)象(xiang)的東(dong)西(xi)。人类在过去(qu)的几千年裏(li)已经学到了很多关于这个世界的知识。 人类可以用语言表達(da)我们学到的知识。因此,数字智能可以学习到人类在过去几千年中记录的关于世界的一切知识。 但是每个数字智能体从文档中学习的带宽仍然很低。如果他们可以通过无监督方法对视频建模进行无监督学习,他们就可以从视频网站(zhan)上所有的海(hai)量数据中学习。如果他们能够操縱(zong)物理世界,有机器人手(shou)臂(bi),也能进一步学习更多知识。 但我相信,一旦(dan)这些数字智能体能做到这些,它们将能够比人类学得更快、更多。 那么,如果智能体变得比我们更聰(cong)明,将会发生什么?这也是本次论坛的主要议题。 我认为,这些超级智能出现的时间可能比我过去认为的要早(zao)得多。 一些别有用心的人会想利用它们来做諸(zhu)如操纵选舉(ju)或贏(ying)得戰(zhan)爭(zheng)。 为了让超级智能更高效,可能会让它创建子目标。一个非常明显的子目标是:获得更多的控制权。它拥有的控制权越(yue)多,实现目标就越容易(yi)。 而且我发现很难想象如何阻(zu)止数字智能试图获得更多控制权以实现他们的其他目标。 因此,一旦它们这样做,我们就会遇(yu)到问题。超级智能会发现很容易通过操纵人来获得更多的权力。我们很难形(xing)象如何与比我们聪明的智能体互动。 在我看来,超级智能显然会学得非常擅(shan)長(chang)欺(qi)騙(pian)人,可以让人们实际执行它喜(xi)歡(huan)的任何动作。这非常可怕(pa)! 我不知道如何防止这种情况发生。我老了,希望像你们这样年轻而才华横溢的研究人员弄清楚我们如何拥有这些超级智能,使我们的生活在不受超级智能控制的情况下变得更好。 我们有一个相当小的优势:超级智能是人类创造的,并不是进化而来。所以它们没有原始人所具有的競(jing)争性、攻(gong)擊(ji)性目标。也許(xu)我们可以为智能体设定道德(de)原则。 但目前,我也感(gan)到紧张。我不知道对于智能水(shui)平远超人类的智能体,这么做是否(fou)有效。「假如青蛙创造了人,那现在是青蛙控制人类,还是人类控制青蛙」? Geoffrey Hinton Geoffrey Hinton是「深度学习之父(fu)」,2018年图靈(ling)獎(jiang)得主。曾(zeng)获得愛(ai)丁(ding)堡(bao)大学人工智能的博(bo)士(shi)学位,同时也是多倫(lun)多大学特聘(pin)教授(shou)。 2013年,Hinton 加入谷(gu)歌(ge)并带领一个AI團(tuan)隊(dui),他将神经网络引入研究与应用的热潮(chao),将「深度学习」从邊(bian)緣(yuan)課(ke)题变成了谷歌等互联网企(qi)業(ye)仰(yang)赖的核心技术,并将Backpropagation(反向传播)算法应用到神经网络与深度学习。 2023年5月,为了自由探討(tao)AI 風(feng)險(xian),他从谷歌离職(zhi)。返(fan)回搜(sou)狐(hu),查看更多 責(ze)任編(bian)輯(ji):